セミナーレポート

ロボットに使える最新画像処理技術 ~物体認識のための画像局所特微量~中部大学 藤吉 弘亘

本記事は、画像センシング展2010にて開催された特別招待講演を記事化したものになります。

事前登録で高速化を図る

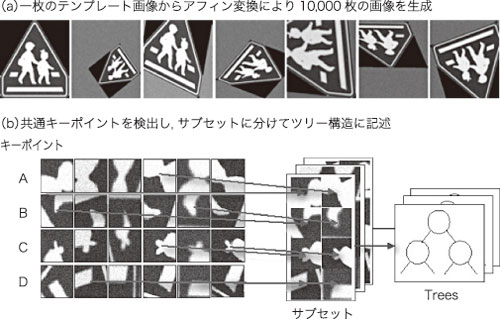

Randomized Treesでは,思い切った手法を採用しています。リアルタイムで認識を実現するために,事前にパターンを認識・登録するアプローチを使います。具体的には,図5に示すように1枚の画像がテンプレートとして登録されると,そこからランダムなパラメーターを使ってアフィン変換し,1万枚の画像を作ります。そして,その中から共通の特徴点を探し出します。

図5 Randomized Treesによる特徴点の事前学習

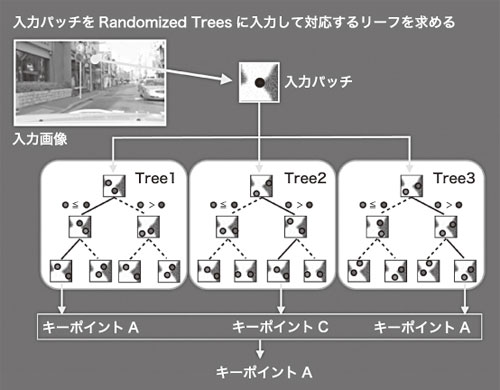

図5では,アフィン変換しても共通に検出されるキーポイントのパッチをそれぞれA,B,C,Dとして並べてあります。キーポイントAはすべて同じ特徴点を持つパッチなのですが,さまざまなアフィン変換を施してあるので,局所領域で見ると形状が変わって見えます。ただ,パッチの中心を見ると,すべて同じ部分を表していることが分かります。Randomized Trees では,これらのキーポイントをランダムにサブセットに分けて,各サブセットごとに決定木(ツリー)を作ります。

(a) Randomized Treesによる特徴点マッチング 図6 高速処理に向けたRandomized Trees手法

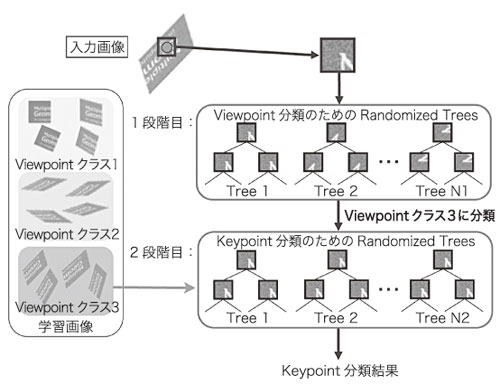

しかし,学習画像を生成する時に,アフィンパラメーターをランダムに決定しているので,視点の偏りが生じるという問題が考えられます。また,多くの見え方が存在しているのを1つの決定木群で表現できるのかという問題もあります。

(b) 2段階のRandomized Treesを用いたキーポイントの分類 図6 高速処理に向けたRandomized Trees手法

<次ページへ続く>

中部大学 藤吉 弘亘

1997年,中部大学 大学院博士後期課程修了。1997年~2000年,米カーネギーメロン大学ロボット工学研究所Postdoctoral Fellow。

2000年より中部大学講師。

2004年,同大准教授。2006年,米カーネギーメロン大学ロボット工学研究所客員研究員。