研究室探訪vol. 14 [埼玉大学 理工学研究科 小室研究室]小室 孝 教授

あの研究室はどんな研究をしているのだろう? そんな疑問に答える“研究室探訪”。

今回は,埼玉大学 理工学研究科 小室研究室にお伺いしました。

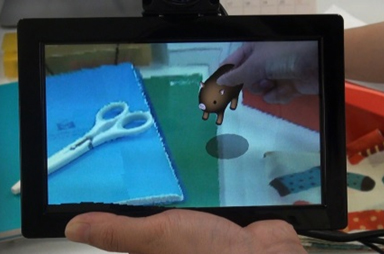

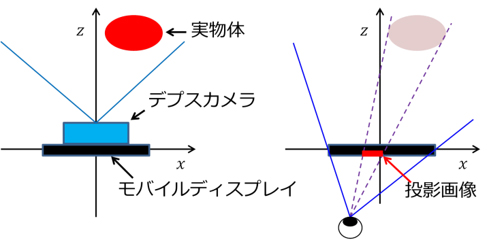

そこで,携帯端末のディスプレイがあたかも透明なガラス板のように透けて見えるようにするシースルーモバイルARシステムを開発した(図1)。端末の後ろのシーンが透けて見えるだけでなく,実シーンに仮想物体を重畳し,手との接触判定を行うことで,仮想物体を手でつかんだり転がしたりといったインタラクションが可能である。デバイスの背面に奥行分布とカラー画像の両方が取得できるデプスカメラ,前面にフェイストラッキング用のカメラを取り付ける。デプスカメラで取得した3次元シーンをユーザーの視点位置に合わせて画面に投影することで,その視点位置から見た映像を表示することができる。本システムにより,画面に表示される自身の手が実際と同じ位置・大きさで表示される。ユーザーが知覚する視覚情報と体性感覚情報が一致するため,違和感の少ない自然なインタラクションが可能になると期待される。

本システムでは多指によるタイピング動作を安定して検出するため,動画像からオプティカルフローを計算し,そこから手指の局所的な動きを検出することで,タイピング動作の認識を行っている。また,120 fpsの高フレームレートカメラを用いることで,指を動かしてから画面に結果が反映されるまでのレイテンシを低減し,高い応答性を実現している。

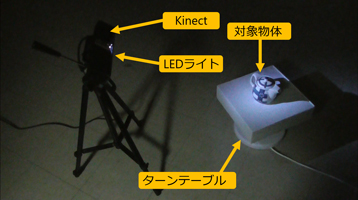

これに対し,我々は簡易な装置を用いて実物体の反射特性を取得し,その3Dモデルをモバイルディスプレイに表示し,さらに手によるインタラクションを可能にすることで,実物体の質感を再現できるARシステムを提案した(図3)。実際に本システムを用いて物体を操作したところ,自身の手の動きに応じて物体が移動・回転するため,あたかもその物体を手に取っているかのように感じられた。また,物体を回転させることで,様々な方向から物体を観察することができ,細かな光沢やつやの変化を感じ取ることができた。

今後の課題としては,表面形状および反射特性計測の精度向上やマーカーレスでの仮想物体とのインタラクションなどが挙げられる。また,物体のリアルな質感を再現できているかどうかを検証するため,被験者を集めて評価実験を行う必要がある。

今回は,埼玉大学 理工学研究科 小室研究室にお伺いしました。

画像処理技術を応用して“新しい”システム作りを

小室研究室は,実世界のさまざまな情報を画像を介して取得する画像センシング技術と,画像を処理・解析し,高度な意味抽出を行うコンピュータビジョンに関する研究をしている。また,これらの技術を応用して,情報端末を使いやすくするための新しいユーザーインターフェイスや,カメラ映像にCGを重畳することで現実空間と仮想空間を融合する拡張現実感の研究のほか,人工知能を活用したシステムや,デジタルサイネージ向けのユーザーインターフェイスなど,技術や社会の進化に対応した研究も積極的に行っている。民間企業と共同で実用化の取り組みも行っている。

小室 孝 教授

2001年 東京大学大学院工学系研究科計数工学専攻博士課程修了,博士(工学) 2001年 科学技術振興事業団戦略的基礎研究推進事業(CREST)研究員 2002年 東京大学大学院情報理工学系研究科システム情報学専攻助手 2005年 東京大学大学院情報理工学系研究科システム情報学専攻講師 2011年 埼玉大学大学院理工学研究科数理電子情報部門准教授 2019年 埼玉大学大学院理工学研究科数理電子情報部門教授 画像センシング,コンピュータビジョン,ユーザーインターフェイス等の研究に従事

2001年 東京大学大学院工学系研究科計数工学専攻博士課程修了,博士(工学) 2001年 科学技術振興事業団戦略的基礎研究推進事業(CREST)研究員 2002年 東京大学大学院情報理工学系研究科システム情報学専攻助手 2005年 東京大学大学院情報理工学系研究科システム情報学専攻講師 2011年 埼玉大学大学院理工学研究科数理電子情報部門准教授 2019年 埼玉大学大学院理工学研究科数理電子情報部門教授 画像センシング,コンピュータビジョン,ユーザーインターフェイス等の研究に従事

[研究テーマ1]シースルーモバイルARシステム

携帯端末を用いたARシステムでは,カメラの位置とユーザーの視点位置が異なるため,画面に映るシーンが現実とは位置や大きさが異なって表示されるという問題がある。そこで,携帯端末のディスプレイがあたかも透明なガラス板のように透けて見えるようにするシースルーモバイルARシステムを開発した(図1)。端末の後ろのシーンが透けて見えるだけでなく,実シーンに仮想物体を重畳し,手との接触判定を行うことで,仮想物体を手でつかんだり転がしたりといったインタラクションが可能である。デバイスの背面に奥行分布とカラー画像の両方が取得できるデプスカメラ,前面にフェイストラッキング用のカメラを取り付ける。デプスカメラで取得した3次元シーンをユーザーの視点位置に合わせて画面に投影することで,その視点位置から見た映像を表示することができる。本システムにより,画面に表示される自身の手が実際と同じ位置・大きさで表示される。ユーザーが知覚する視覚情報と体性感覚情報が一致するため,違和感の少ない自然なインタラクションが可能になると期待される。

図1 シースルーモバイルARシステムと視線位置に合わせた投影

[研究テーマ2]ARタイピングインターフェイス

スマートフォンなどの携帯端末の多機能化により,携帯端末上でいろいろな作業を行う機会が増えている。しかし,小型の携帯端末では,細かい操作をすばやく行うことが難しいという問題があった。そこで,カメラを用いて,操作空間を機器表面から空中に移すことを考え,携帯端末の画面に表示されたソフトウェアキーボードを,片手5本の指を用いてタイピングできるユーザーインターフェイスを作成した(図2)。ユーザーが携帯端末の後ろの空間に手をかざすと,画面上のソフトウェアキーボードの上に手の画像が重畳表示される。手指を動かしてキーを打つ動作をすることで,動かした指の上にあるキーが入力される。ソフトウェアキーボードの上にユーザーの手の画像を重畳表示することで,ユーザーが自分自身の手でキーを押しているという感覚を与え,直感的な操作を実現している。本システムでは多指によるタイピング動作を安定して検出するため,動画像からオプティカルフローを計算し,そこから手指の局所的な動きを検出することで,タイピング動作の認識を行っている。また,120 fpsの高フレームレートカメラを用いることで,指を動かしてから画面に結果が反映されるまでのレイテンシを低減し,高い応答性を実現している。

図2 ARタイピングインターフェイス

[研究テーマ3]モバイルARによる質感再現システム

近年,インターネット通販などの普及により,オンラインで製品を見たり購入したりすることができるようになってきた。しかしながら,ユーザーは実際に製品を手に取って見ることができないため,その質感がわからないといった問題がある。これに対し,我々は簡易な装置を用いて実物体の反射特性を取得し,その3Dモデルをモバイルディスプレイに表示し,さらに手によるインタラクションを可能にすることで,実物体の質感を再現できるARシステムを提案した(図3)。実際に本システムを用いて物体を操作したところ,自身の手の動きに応じて物体が移動・回転するため,あたかもその物体を手に取っているかのように感じられた。また,物体を回転させることで,様々な方向から物体を観察することができ,細かな光沢やつやの変化を感じ取ることができた。

今後の課題としては,表面形状および反射特性計測の精度向上やマーカーレスでの仮想物体とのインタラクションなどが挙げられる。また,物体のリアルな質感を再現できているかどうかを検証するため,被験者を集めて評価実験を行う必要がある。

図3 実物体の反射特性計測シーンと質感再現システムの動作例

小室研究室より

多くの人に“すごい”と思わせるような研究を目指していきたいと思う一方,“新しい”“すごい”システムを作るには,それなりの労力がかかるものである。当研究室では,教員の指導以外にも先輩の手厚いサポートや学生どうしの助け合いによって,研究が少しでもスムーズに進むような仕組みを作っている。また,外部の研究室との連携・交流などを通じても,成長の機会が得られると思っている。そうしたなかでの研究の成果は,積極的に学会での発表をするように促している。

埼玉大学 理工学研究科 小室研究室

住所:〒338-8570 埼玉県さいたま市桜区下大久保255

埼玉大学 情報システム工学科棟 522号室

TEL: 048-858-9211

E-mail:komuro@mail.saitama-u.ac.jp

URL:http://www.is.ics.saitama-u.ac.jp/index.html

![研究室探訪vol.30 [奈良先端科学技術大学院大学 サイバネティクス・リアリティ工学研究室]](https://www.adcom-media.co.jp/wp-content/themes/adcom/scripts/timthumb.php?src=/wp-content/uploads/2022/11/laboratory1.jpg&w=40&h=40&zc=1&q=100)

![研究室探訪vol.29 [大阪大学 山本・生田研究室]](https://www.adcom-media.co.jp/wp-content/themes/adcom/scripts/timthumb.php?src=/wp-content/uploads/2022/09/laboratory1.jpg&w=40&h=40&zc=1&q=100)

![研究室探訪vol.28 [東海大学 藤川研究室]](https://www.adcom-media.co.jp/wp-content/themes/adcom/scripts/timthumb.php?src=/wp-content/uploads/2022/07/laboratory1.jpg&w=40&h=40&zc=1&q=100)

![研究室探訪vol.27 [東京大学 生産技術研究所 志村研究室]](https://www.adcom-media.co.jp/wp-content/themes/adcom/scripts/timthumb.php?src=/wp-content/uploads/2022/05/laboratory1.jpg&w=40&h=40&zc=1&q=100)

![研究室探訪vol.26 [慶應義塾大学 神成淳司研究室]](https://www.adcom-media.co.jp/wp-content/themes/adcom/scripts/timthumb.php?src=/wp-content/uploads/2022/03/laboratory1.jpg&w=40&h=40&zc=1&q=100)

![研究室探訪vol.25 [東京大学 竹内 渉研究室]](https://www.adcom-media.co.jp/wp-content/themes/adcom/scripts/timthumb.php?src=/wp-content/uploads/2022/01/laboratory1.jpg&w=40&h=40&zc=1&q=100)

![研究室探訪vol.30 [奈良先端科学技術大学院大学 サイバネティクス・リアリティ工学研究室]](https://www.adcom-media.co.jp/wp-content/themes/adcom/scripts/timthumb.php?src=/wp-content/uploads/2022/11/laboratory1.jpg&w=80&h=100&zc=1&q=100)